大模型智能体之Chatbox

1.Chatbox

链接本地模型

考虑到Ollama的cmd黑窗口不方便,所以我们开发了一款Chatbox AI,方便本地部署和聊天使用

Chatbox AI 是一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用

Chatbox AI旨在为用户提供一个简单易用的可视化界面,让非专业技术人员也能便捷地与各种AI模型进行交互

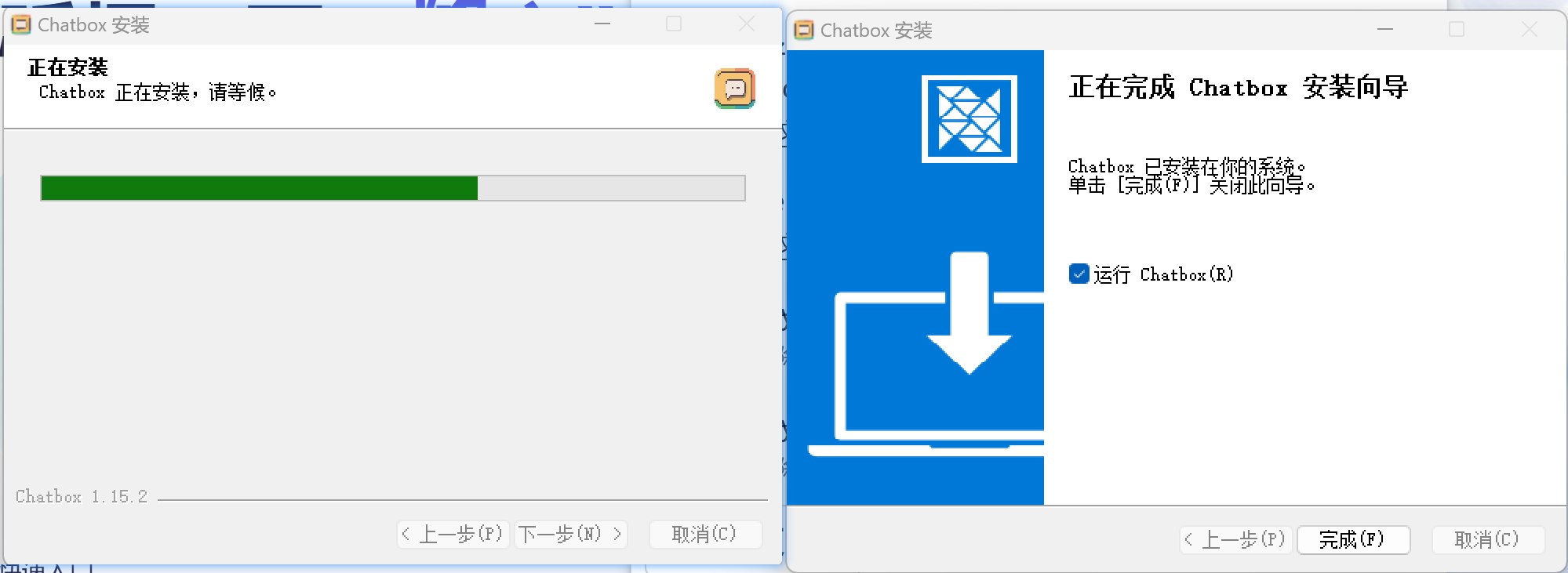

在官网点击下载后,安装此程序,如下👇

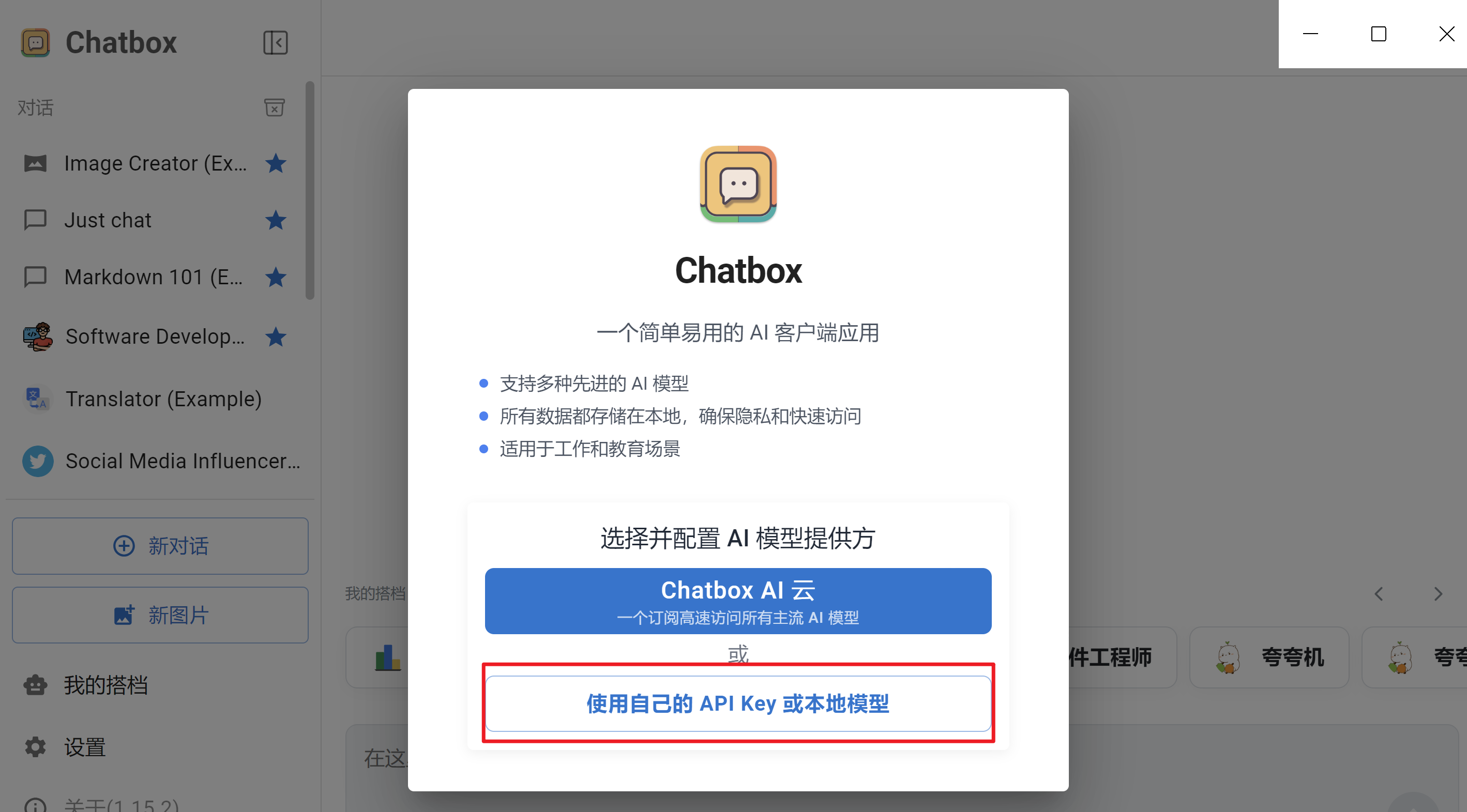

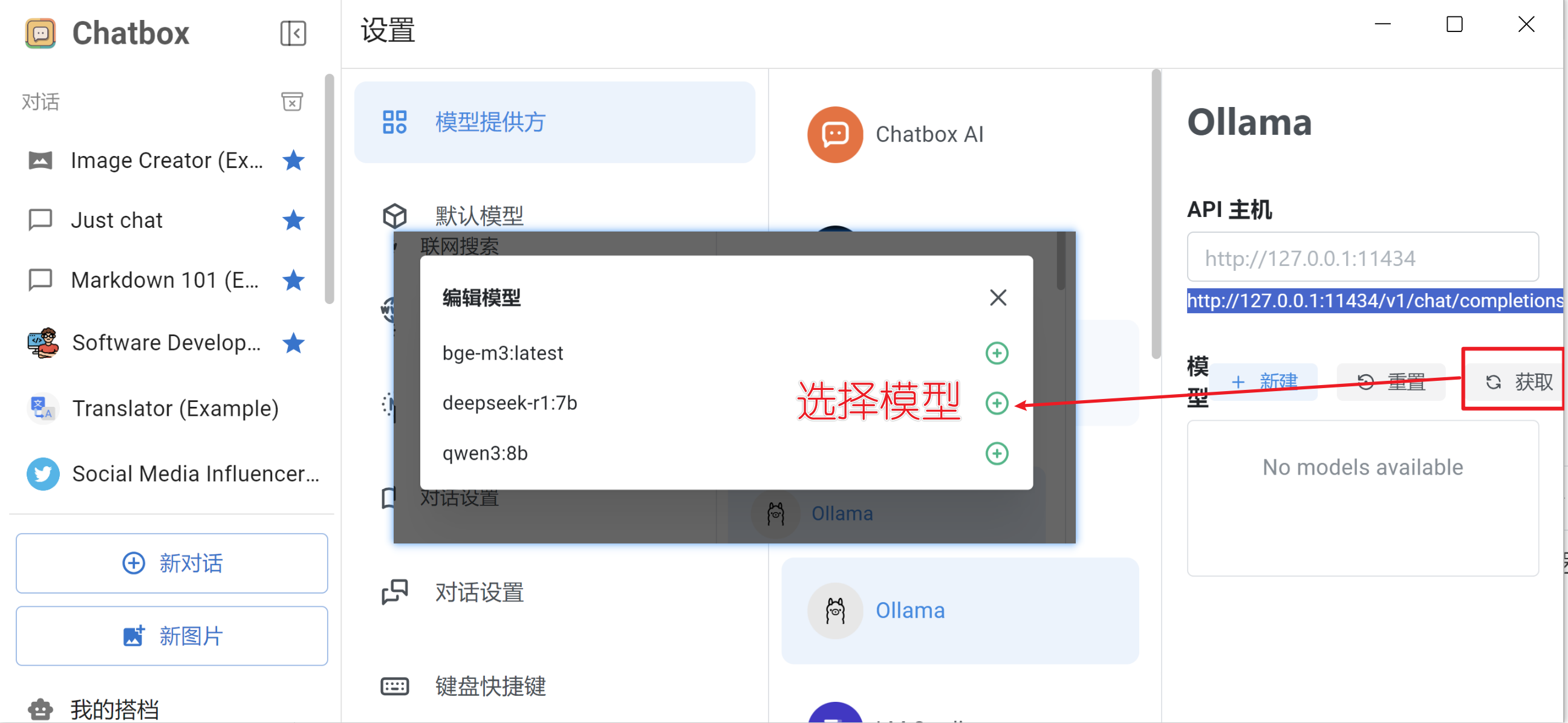

安装后后,启动,设置关联到本地模型

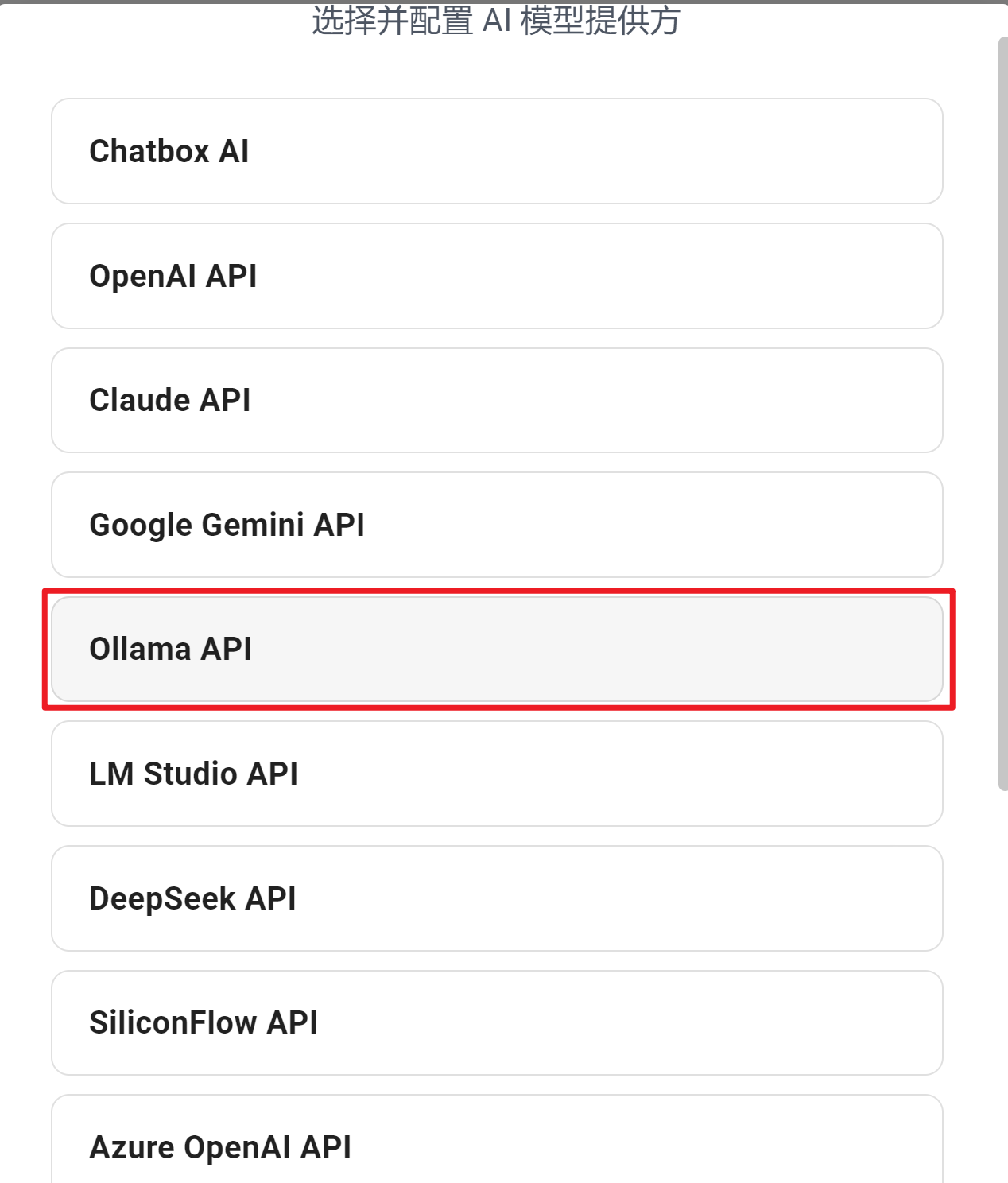

AI模型配置选择Ollama

在模型列表中,选择已经启动的模型(注意 :此时需要先使用ollama运行模型)。

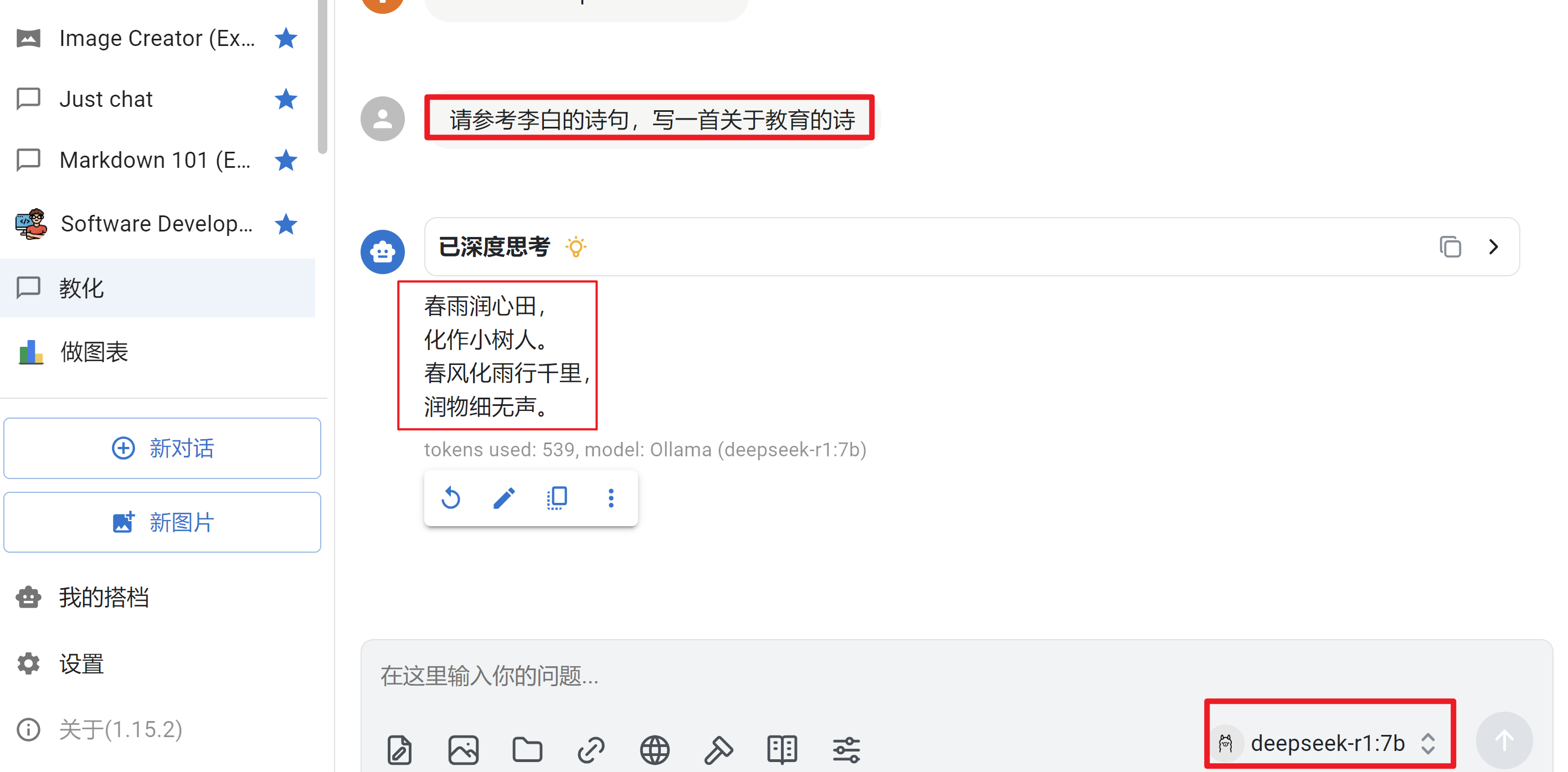

接下来就可以使用了,测试一下中文效果,测试一下英文效果

至此,可以使用Chatbox来与AI聊天了。但是交流的都是通用知识,如果需要读取私有文件的中内容,来回答问题的话,显然不足。

2.Chatbox链接三方模型

前言

deepseek官网:https://deepseek.com/zh/ ----->右上角--->api开放平台--->注册账号--->创建应用--->获取API Key

qwen官网:https://qwen.ai/zh/ ----->

3.RAG知识讲解

前言

1 什么是RAG?

RAG(Retrieval-Augmented Generation)检索增强生成是一种将信息检索与大语言模型(LLM)结合的框架。简单来说:

RAG(中文为检索增强生成) = 检索技术 + LLM 提示。

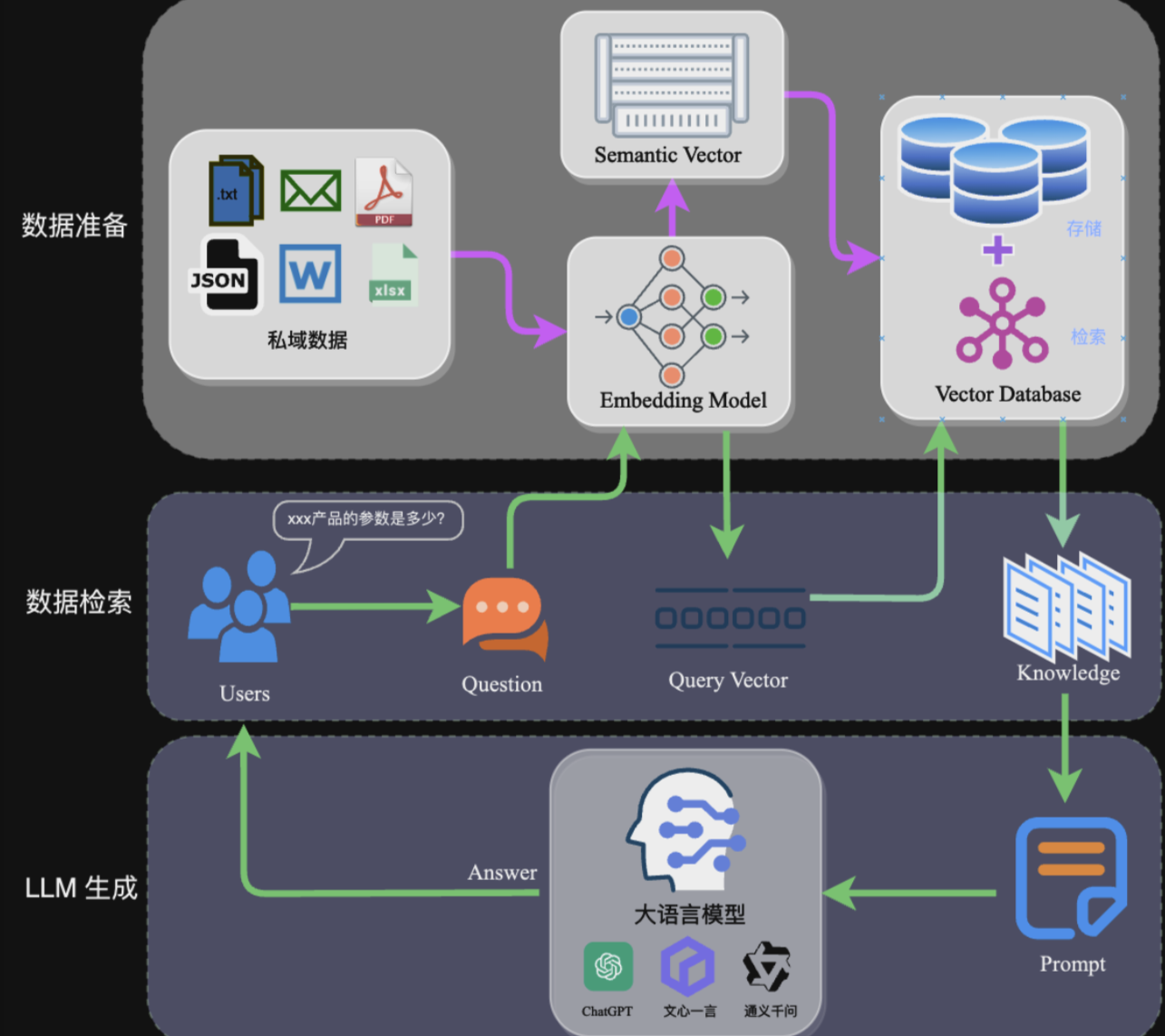

核心工作流程:

- 检索阶段:从知识库中找到与用户查询最相关的知识片段

- 生成阶段:将检索到的知识与用户问题一起输入LLM,生成最终答案

完整的RAG应用流程主要包含两个阶段:

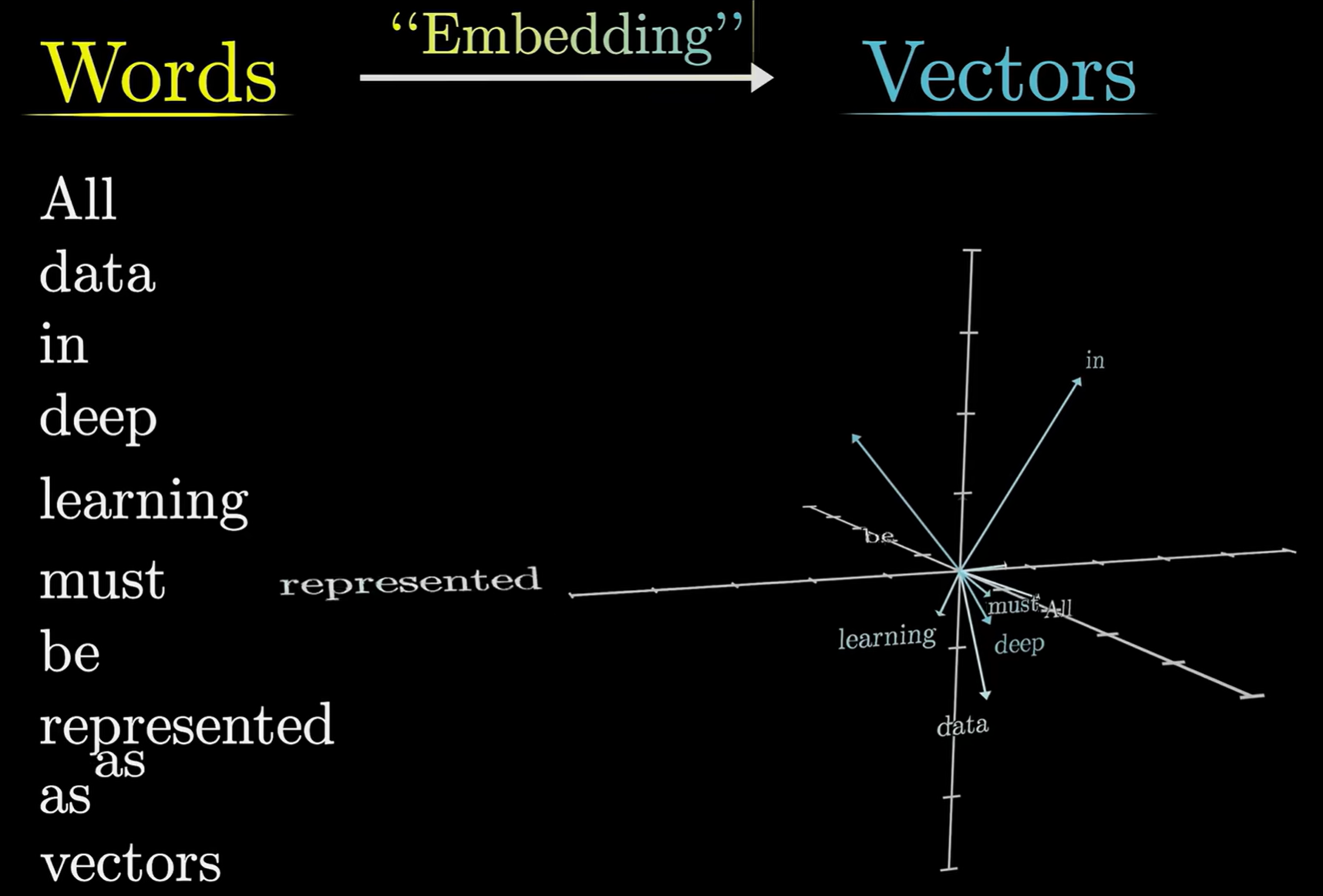

- 数据准备阶段:数据提取——>文本分割——>向量化(embedding)——>数据入库

- 应用阶段:用户提问——>数据检索(召回)——>注入Prompt——>LLM生成答案

embedding Model:负责将文本向量化. vector DB:负责存储和检索多维向量

image

2 为什么需要 RAG?

LLM 的痛点:

- 知识截止时间早,无法获取最新信息

- 企业私有数据无法访问

- 容易产生"幻觉"(胡说八道)

- 数据安全和隐私问题

3 什么是BGE-M3

BGE-M3(BAAI General Embedding M3) 是一个强大的多功能嵌入模型,同时支持密集检索、多向量检索和稀疏检索,非常强大,它适用于多种使用场景,比如检索增强生成、知识检索问答、文本检索、分类和聚类。

- 每个模型都有文本限制,如果不分块,根本无法将完整文档信息提供给 LLM!

- 在向量数据库中,任何内容都需要先进行 Embedding,

- 分块的主要目的是:

- 减少噪音:避免将不相关信息一起向量化,

- 提高匹配精度:小块更容易找到精确匹配

- 优化存储:向量数据库处理小块更高效

4 什么叫知识库

知识库 更加偏向于能够直接读取文档并处理大量信息资源,包括文档上传、自动抓取在线文档,然后进行文本的自动分割、向量化处理,以及实现本地检索增强生成(RAG)等功能的工具.

像是企业的"大脑",个人的"书架",AI的"知识库"——它让分散的知识变得有序、有用、有价值!

综合来说,要提高模型的准确性和私密性,可以利用RAG技术来实现,可以使用bge-m3来进行构建知识库。

3 创建本地知识库

创建本地知识库

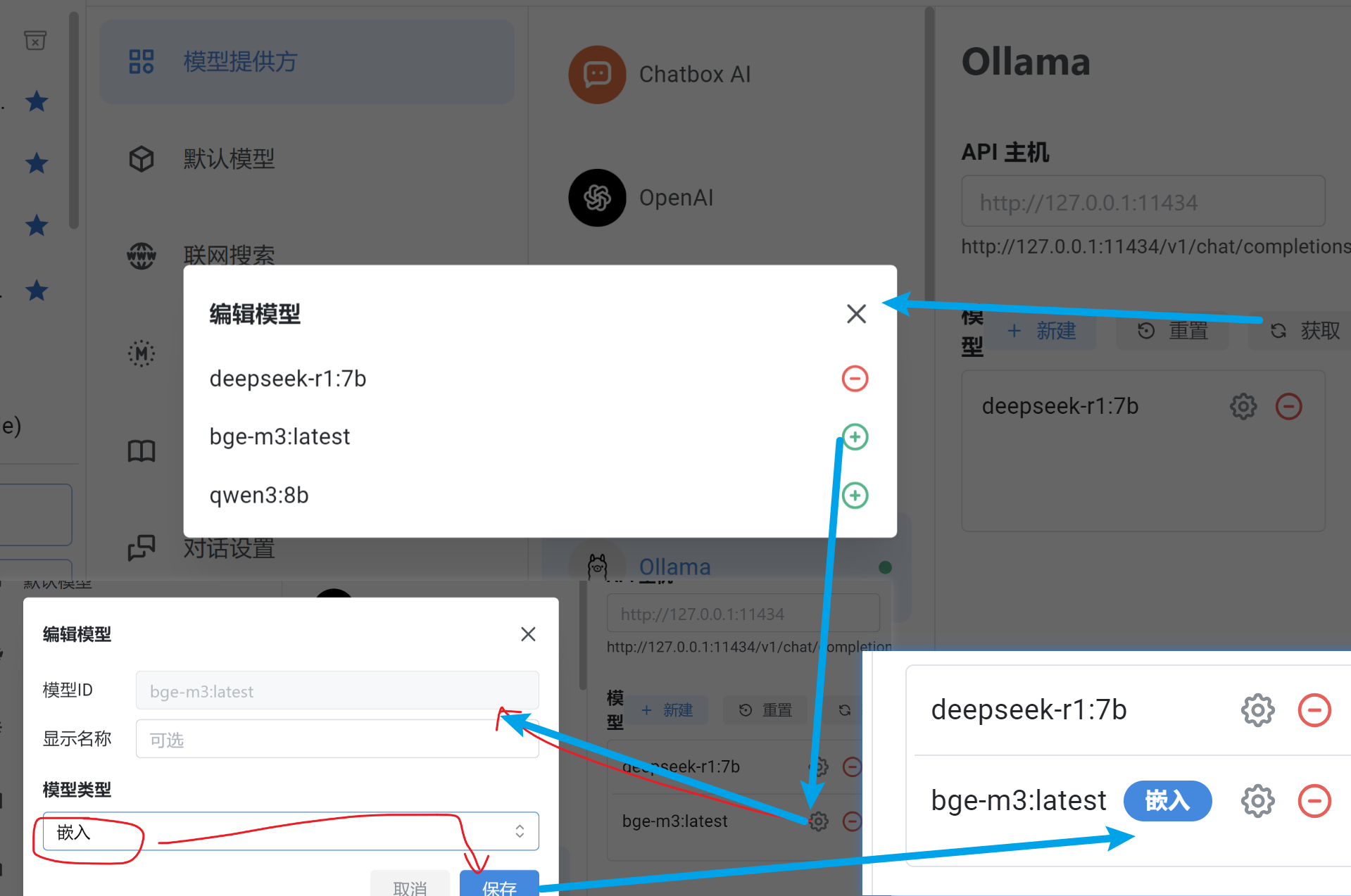

0. 在ChatBox AI 中设置页面中添加嵌入模型

1. 创建知识库

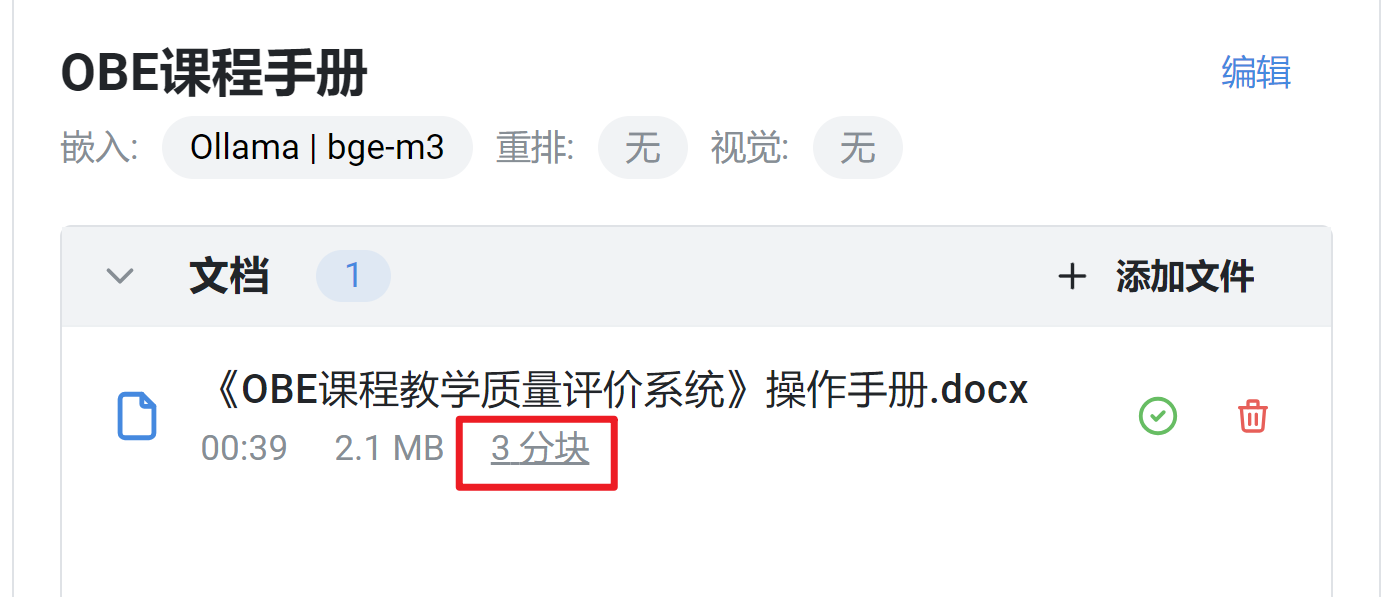

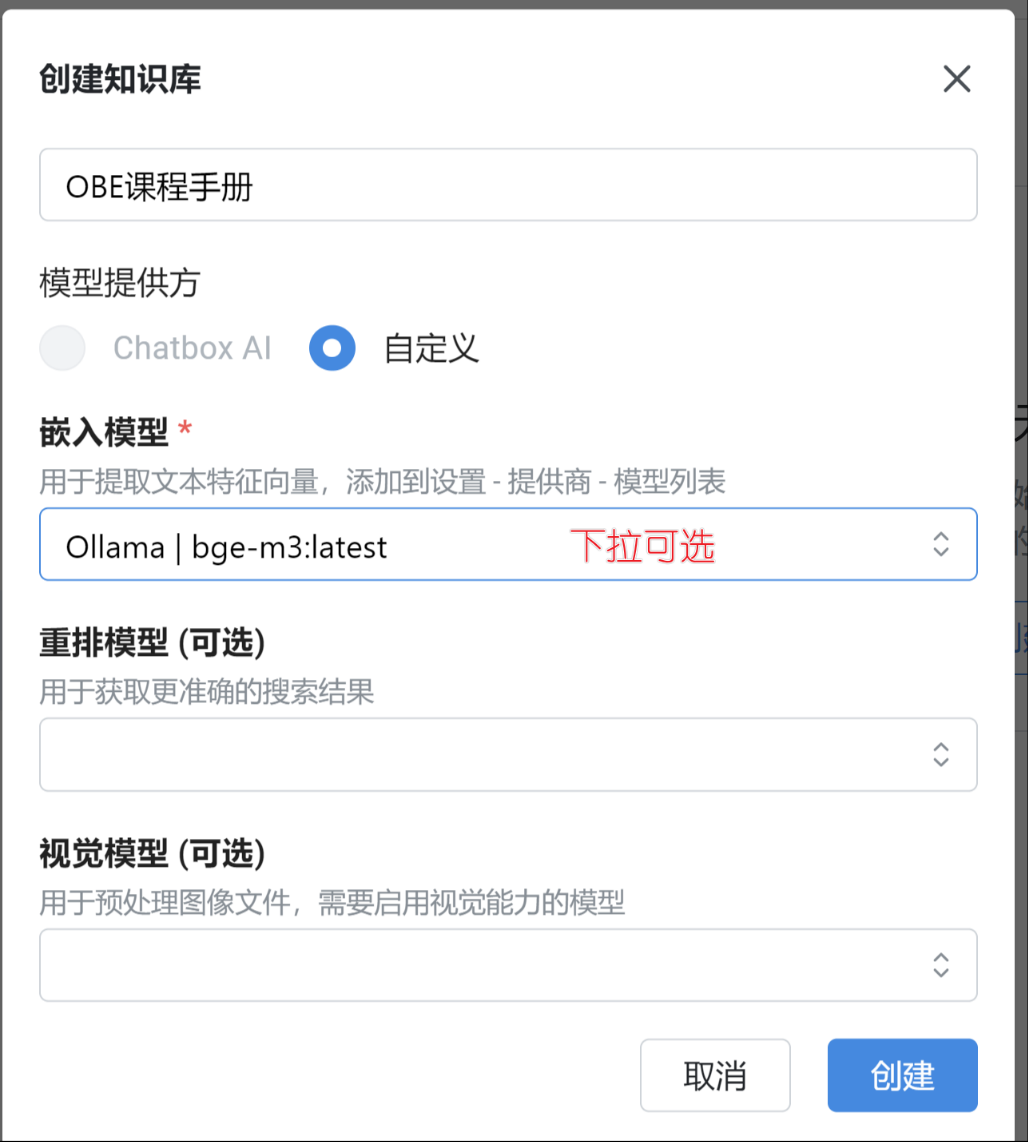

进入设置 - 知识库 页面,点击创建知识库,输入知识库名称,并选择知识库所需要的模型

对于 Chatbox AI 付费用户,可以选择 Chatbox AI 作为知识库的模型提供方,免费用户也可以选择自己的API。

嵌入模型:用来将文档转换为向量

重排模型:可选 ,配置后可以获得更准确的搜索结果,对回答质量有一定帮助

视觉模型:可选 ,配置之后,可以往知识库里添加图片,图片中的文字会被提出来入库

2. 往知识库添加文档

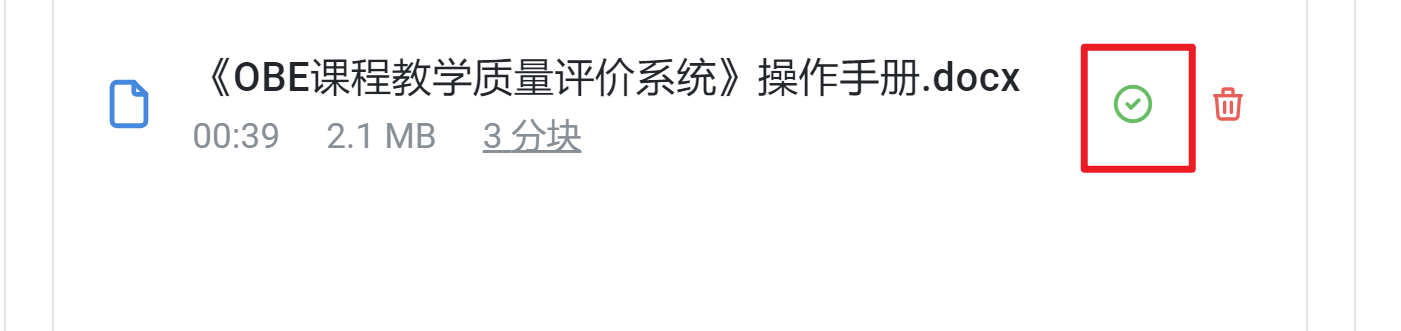

拖入或点击浏览文件,等待文件处理完成。’

3. 对知识库进行问答

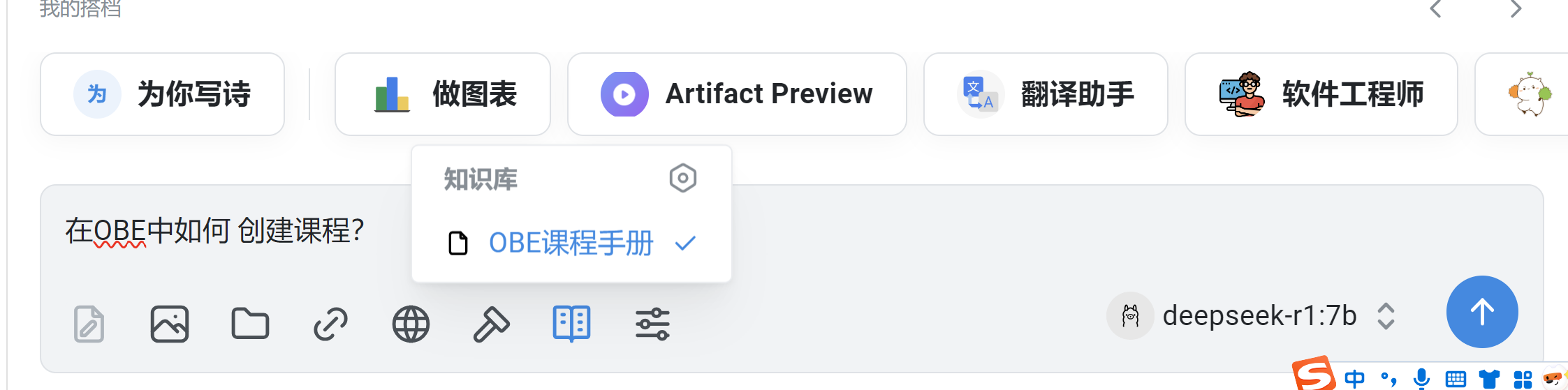

创建新对话,在输入框里的工具栏选择刚刚创建的知识库

然后就可以随意问答了

可以发现,回答的结果是根据资料返回的,不是不变乱造!!

总结

课堂作业

- 你可以根据上述教程,一起来构建属于你的特有的知识库吧!!🎤